スマホの音声入力では、マイクに向かってしゃべった声が、リアルタイムに文章として入力されます。その裏側を支えているのが「音声認識」。声を分析し、文字のデータに変換する技術です。「Alexa、電気消して」も「Hey Siri、明日の天気は?」も、音声認識なしには実現しません。

最近では、会議の音声から議事録を作ったり、音声で作業記録を付けたりなど、音声認識の用途は拡がりを見せているそう。一方で、「インタビューの文字起こしがうまくいかない」など、思うように認識されないという声も耳にします。

そもそも、音声認識はどうやって人間の声を認識しているのか? 日本語の音声認識はどこが難しいのか? 音声認識ソリューションを手がける株式会社アドバンスト・メディアの安藤さんに、音声認識の気になる裏側を聞きました。

1997年に創業し、音声認識技術「AmiVoice」をコアとした各種ソリューションを提供。医療、コールセンター、製造、物流、不動産など、多数の領域特化型の音声認識エンジンを有し、日本の音声認識市場をけん引する。

お話を伺った安藤章悟(しょうご)さんは大学で音声認識の研究を学んだ後にアドバンスト・メディアに入社。プロダクトマネージャーとして、医療業界向けの「AmiVoiceEx」やコールセンター向けの「AmiVoice Communication Suite」などを手掛ける。

音声認識は「音の領域」と「言語の領域」のハイブリッド技術

――今日は音声認識についていろいろ伺いたいのですが……安藤さんのマイク、すごく本格的ですね。

▲本格的なラージダイアフラムタイプのコンデンサーマイクを使用する安藤さん。このタイプのマイクは高感度で音楽制作にも使われるもの。一般的なイヤホンマイクは電源不要な「ダイナミックマイク」やわずかな電力で駆動する「エレクトレットコンデンサーマイク」などが多い

安藤さん:ありがとうございます(笑)。職業柄、オーディオが好きでして。ただ、音声認識のためにここまでのマイクは必要ないんですよ。音声認識にはヘッドセットのほうが適していますね。

――そうなんですか? 良い音質ほど正しく認識してくれそうですが……。

安藤さん:高性能なマイクだと繊細な音の違いが分かったりしますが、音声認識で「何と喋っているか」を聞き取るぶんにはそこまでの高音質は必要ないです。音声認識にとってもっと重要なのは「口とマイクが常に近くにある」こと。私が使っているタイプのマイクだと話者が動くとマイクから離れてしまいますが、ヘッドセットはマイクと口の距離が常に近く一定なので、音声認識やビデオ会議に向いているんですよ。

――なるほど……。音質が音声認識にそれほど影響しないとなると、音声認識技術は実際どのように人の声を認識しているんですか?

安藤さん:大きく分けて2つの手法があります。1つめは、音声を「音の領域」と「言語の領域」に分けて処理するハイブリッドな方式。弊社では現在、この方法が主流ですね。

まず、マイクから入ってきた声を、数十分の一秒レベルで細かく区切ります。そして、区切られた音声ひとつひとつに対し、「ここは『あ』の音っぽいな」「ここは『い』かな」と分析するんです。

ただ、音の種類は「あいうえお」の五十音だけではありません。例えば同じ「あ」でも、「い」から続いて出た「ぃあ」と、「う」から続いて出た「ぅあ」では、口の動きや形が違うんですね。

――人の発話は直前のものをうけて音が微妙に変わるので、ロボットみたいに「ワ・タ・シ・ハ」と区切って発音するわけじゃないと。

安藤さん:その通りです。口の形が変わると音の特徴も異なるので、「あ」だけでも複数のパターンを用意します。これでマイクから入った音をひらがなに変換できるんですが……そのままでは全く正確な文章にはなりません。

……ちょっと前の話で恐縮ですが、「オンドゥル語」ってご存じですか?

――わかります。某特撮ドラマで、俳優の滑舌が悪かったために「本当に裏切ったんですか!」が「オンドゥルルラギッタンディスカー!」と聞こえるとネットで話題になった……。

安藤さん:それです。音をそのままひらがなに変換すると、まさにその状態が起こります。オンドゥル語は極端な例ですが、人はひらがな通りに発音しているわけではないんです。例えば「静岡」と言ったときに「しずおか」なのか「しぞーか」なのか、人間でも判別が難しいことがありますし、喋った音声をそのまま完璧にひらがなに変換するのはそもそも困難なんです。

そこで登場するのが「言語の領域」です。ここでは、変換されたひらがなを、"単語としてありえるもの”に補正します。滑舌が悪くて「おはのう」と分析されたとしても、このタイミングで、「ここは『おはよう』だろうな」と直してあげるんですね。

――確かに日常でも、「ありあとございま~」と聞こえても「これは『ありがとうございます』だな」ってわかりますもんね。

安藤さん:あとは、「文章として続きそうな単語かどうか」という情報を使った補正も行います。「今日の天気は」と言われたら、次は「晴れ」「雨」とか、「良い」「悪い」、「こちら」などが出る可能性が高いですよね。「次にどんな単語が続くか」という”つながり”の情報から、最も確率が高そうなものを選んで補正してあげるんです。

「音の領域」で音声をひらがなに変換し、「言語の領域」でより正しい文章に直す。音声入力では、これをリアルタイムに繰り返してテキストを出力しています。これがハイブリッドの方式です。

――ということは、「オンドゥルルラギッタンディスカー!」も、現代の音声認識技術を駆使すれば……?

安藤さん:「音の領域」「言語の領域」のデータを、この俳優さんの声やドラマの内容向けに特化すればいけるかもしれないです。難易度は高いと思いますが……。

――そういえば、音声認識のやり方は「大きく分けて2つある」って言っていましたよね。もうひとつの方法はどういうものですか?

安藤さん:もうひとつは「End To End」と呼ばれる方式で、ディープラーニングを活用した比較的新しい方式です。ハイブリッド方式でもディープラーニングは「音の領域」「言語の領域」でそれぞれ使われているのですが、End to End方式では音や言語でわけずに、「この音はこういう内容を喋ってます」という情報を、そのままディープラーニングで学習します。

End to End方式はまだ課題もあるのですが良い成果も出てきており、今後が期待されています。ディープラーニングの登場以降、音声認識技術も日々改善されていますが、これによってさらに次のステップに進むかもしれませんね。

同音異義語、単語の区切り……日本語の音声認識を悩ませるポイント

――ライターという職業柄、インタビュー音源の文字起こしに音声認識を試してみることがあるんです。でも、なかなかうまくいかないことも多くて……。もしかして、日本語は他の言語と比較すると、音声認識が難しい言語なのでしょうか?

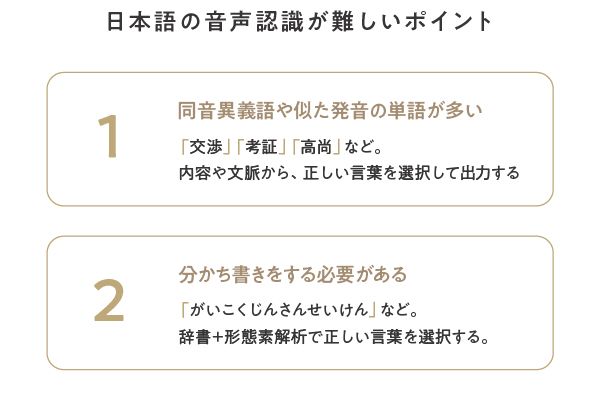

安藤さん:音声認識はさまざまな技術要素が絡み合っているので、単純にどの言語なら認識しやすい・しにくい、と断言するのは難しいのですが、日本語は母音や子音が他の言語と比べて少ないという特徴があって、この点は難易度に影響があるのではないかと思います。

母音や子音が少ないと、「音の領域」で音を割り当てる選択肢が狭まるので、文字を当てはめるのは楽になります。その代わり、似た発音の言葉や同音異義語が増えてしまうので、「言語の領域」で判断するのが難しいんですね。

――「言語の領域」で文脈を判断しないと、「紅葉の時期に柿がなる(こうようのじきにかきがなる)」が、「紅葉の磁気に牡蠣が鳴る」みたいになってしまうわけですね。

安藤さん:そうです。あとは同音異義語だけではなく「紅葉(こうよう)」と「雇用(こよう)」のような似た発音の単語が出てしまうこともあるので、そこも文脈を使った補正をする必要があるんです。こういった同音異義語や似た発音の単語を正確に判断するにはたくさんの文章データが必要になりますが、日本語ではこうしたデータを学習するのもまた大変なんですよ。日本語は「分かち書き」がないので。

――「分かち書き」とはなんですか?

安藤さん:単語と単語のあいだに空白を入れる書きかたです。英語などほとんどの言語では単語と単語のあいだにスペースが入りますが、日本語や中国語、タイ語など一部の言語は文章中の単語が全てつながっているんですね。

つまり、文章から単語のつながりを学習する前に、「単語を区切る」処理を入れなければならない。例えば、「外国人参政権」なら、私たちは「外国人」と「参政権」で区切るんだとわかるんですが、処理を間違えると「外国」「人参」「政権」で区切ってしまうわけです。

このまま学習すると「外国」という単語の後には「人参」が来やすい、という誤った学習をしてしまうことになります。

――輸入品の野菜に政権が渡ってしまいました。

安藤さん:この処理は「形態素解析」といって専用のエンジンを使う処理なのですが、完璧なものを作るのは難しいので適宜手間をかけて辞書やロジックをメンテナンスしています。

――他にも、精度を上げるためにどんな工夫がなされているのでしょうか?

安藤さん:簡単なものとしては、同じ単語でも話者によって読みが違うことがあるので、単語に複数の読みを振ることがあります。「シミュレーション」の読み方に「シュミレーション」も含めれば、どちらを言われても「シミュレーション」を返せるわけです。「せんたくき」と「せんたっき」、「プラスチック」と「プラッチック」などもそうですね。

あと、弊社では「利用シーンに応じた専用の音声認識エンジンを用意する」ということもやります。コールセンターで利用するなら電話越しの声、工場で利用するなら騒音も含めた声、というように、利用シーンに合わせた発話データを学習させるんです。

――その場にそった声を使って「音の領域」で認識しやすくするんですね。では「言語の領域」も、利用シーンに応じて変えるのでしょうか?

安藤さん:はい、もちろん「言語の領域」でも、利用シーンに合わせて学習データを切り替えています。業界に特化した専門用語を正確に認識するには、専用の音声認識エンジンが必要不可欠です。

例えば弊社は医療業界向けに電子カルテを音声入力するプロダクトを提供していますが、そこでは医療業界に特化した音声認識エンジンを用いています。このエンジンには医療に特化した辞書が入っているので、例えば「左下腿開放性骨折の観血的整復固定術を施行した」のような専門用語を含む文章も、スムーズに音声認識できるんですよ。

音声認識の開発者が「最新トレンド」もチェックする理由

――「専門用語を認識するためには専用の辞書が必要」ということは……世の中に新しい言葉が出てきたら、それも辞書に追加しないといけない、ということですか?

安藤さん:その通りです。音声認識では、いくら「音の領域」で正確に認識しても、辞書にない言葉を出力することはできません。「言語の領域」で、辞書にあるなかで一番近そうな言葉に補正されてしまうんです。

なので、汎用的な音声認識エンジンでは小まめに辞書を更新して、新しい言葉を追加しています。私たちも結構頑張ってトレンドを追っているんですよ(笑)

――そんなご苦労が……。「辞書づくり」って、例えば他にどんなことをするのでしょう?

安藤さん:やるべきことはたくさんありますが、「使われなくなった言葉を辞書から消す」といった処理が必要になることもあります。膨大な学習データのなかには、「これまで数回しか出てこなかった単語」みたいなものも結構あるんですよ。

残すこともできるんですが、それが逆に誤変換の原因になることもあるので。認識精度や出現回数の数値を見て、一定の回数以下の言葉は削るなど、バランス調整を図っています。

▲アドバンスト・メディアのWEBサイトより。同社では汎用性の高い音声認識ソフトだけでなく、コールセンターや医療従事者向けのプロダクトも開発・提供している

――いかに「音の領域」と「言語の領域」でデータを充実させるかが鍵なんですね。それってもしかして、僕の声だけで専用の音声認識エンジンを作ったら、めちゃくちゃ認識できるのでは……?

安藤さん:それはもう、めちゃくちゃ認識しますよ!

――やっぱり!

安藤さん:ただ、データを用意する労力もめちゃくちゃかかりますので……。私たちが苦労しているのも、まさにデータ集めですから。

例えばコールセンターの通話を音声認識するためのエンジンを作るとしたら、オペレーターとお客様でどんな内容の会話がなされているか、そのデータが必要です。もちろん、そんなデータはどこにもないので、実際に耳で聞いて書き起こさねばなりません。

「言語の領域」のデータをゼロから作ろうと思ったら、何百時間、何千時間、それ以上の書き起こしたデータを用意するのが理想です。会話データはセキュリティ上の問題につながることも多く、厳重な管理もせねばなりませんし……。

――気が遠くなりますね……。そこからさらに、お客様から要望を受けることもあるんですか?

安藤さん:「音声認識結果をもっと使いやすくするために表記揺れをなくしてほしい」という要望はありますね。

例えば「といあわせ」という単語ひとつでも、「問合せ」「問い合わせ」「問いあわせ」など、表記が揺れることがあります。あとは記号やアルファベットなどの半角・全角、大文字・小文字などが揺れると使いにくくなることがあるので、表記を統一するように学習データを整備します。ただ用途や業界によってどんな表記を出すべきかが変わることもあり、そういった配慮も必要になるのが難しいポイントです。

▲アドバンスト・メディアによるテックブログでも定期的に記事執筆を手掛ける安藤さん。ちなみに、同社エンジニアの方々は「システム側が聞き取りやすい発声の仕方」を知っているばかりに、テストで音声認識を使用する際、一般の人が使うよりも精度高く、喋った言葉が「認識されてしまう」のだとか。

安藤さん:音声認識結果の使いやすさでいうと、音声認識結果の表現にも苦労しています。例えば数字だと「せんごひゃくえん」は「1500円」や「1,500円」に変換したほうが読みやすいですが、だからといって「いっちょうえん」を「1000000000000円」と表記すると読みづらい。「にさんぜんえん」も「23000円」ではなく「2~3000円」にするべきでしょう。

言われた通りに表示するのではなく、いかに使いやすいテキストにするか。弊社の音声認識エンジンでも工夫を続けているところです。

コロナ禍で音声認識のニーズが増えている!?

――アドバンスト・メディアさんでは、さまざまな音声認識ソリューションを提供されていますよね。音声認識の精度が向上すると共に、市場が広がっているということでしょうか。

安藤さん:そうですね。昔は音声認識精度が悪くて、アナウンサーのように丁寧に喋らないと使い物になりませんでした。人と人との会話のような、少し雑な喋りかたをするシーンでは誤認識が多くて使えなかったのですが、徐々に精度が上がってきて。今では、例えばコールセンターの通話でも音声認識が使われるようになりました。

コールセンターでは管理者が各オペレーターの対応をモニタリングすることがあるんですが、音声だと同時に1人ぶんの会話しか確認ができません。音声認識によって会話をリアルタイムで文章化すれば、複数人の会話内容をモニター上に並べ、「目」で俯瞰することができるわけです。

最近はコロナ禍により、オペレーターが在宅で対応する「在宅コールセンター」も増えてきました。音声認識なら、離れた場所でもオペレーターの通話を可視化できるので、よりニーズが増している状況ですね。

▲アドバンスト・メディアによる音声認識システム「AmiVoice」を使ってみたい場合は、「UDトーク」がおすすめ。画像はWebサイトより

――コロナ禍で音声認識のニーズが増えている、というのは面白いですね。

安藤さん:Zoomなどのオンライン会議が増えたのも、追い風になっているんですよ。会議参加者の音声がクリアに録れるので、音声認識を使った議事録が取りやすくなりましたから。

誰が話しているか判別する技術を用いて、会話をリアルタイムに字幕として出すことも可能です。この機能があれば、聴覚に障がいがある方も会議に参加しやすくなります。

――スマホの音声入力や、声で操作するスマートスピーカーなど、音声認識が身近になった一方で、国内海外含めライバル企業も増えたのではないでしょうか。

安藤さん:そうですね。音声認識は難易度が高く大量のデータも必要、という参入障壁が高い技術なので、増えてはいるものの、それなりに把握できるくらいの数だと思います。最近ではGoogleやAppleなどの巨大企業もライバルになってきました。

よく出来ていて、精度もそれなりに高いので驚異と感じる部分もありますが、我々には日本語の音声認識に関する多くの経験やデータがあるので誰にも負けない自負があります。

それと巨大企業の音声認識はたいてい汎用的な、「なんでもそこそこ認識できる音声認識」なので、高い精度が求められるシーンや専門分野だとうまく使えないことがあります。我々は「用途を特化した高精度な音声認識」も作ることができるので、医療業界やコールセンター業界などのビジネス分野でも広く受け入れられています。

ライバルが増えたということは、裏を返せば、音声認識という技術が普及してきたことを意味します。より精度を向上させることで、音声認識を使いこなす人が増えれば、我々が思いつかないような新たな用途も生まれ、市場も盛り上がっていくでしょう。

音声認識がただの技術としてではなく、文化として、生活のなかに自然に溶け込むようになったら嬉しいですね。

文=井上マサキ/図とイラスト=藤田倫央/編集=伊藤 駿(ノオト)